[파이썬] xgboost 조기 종료 기능 활용

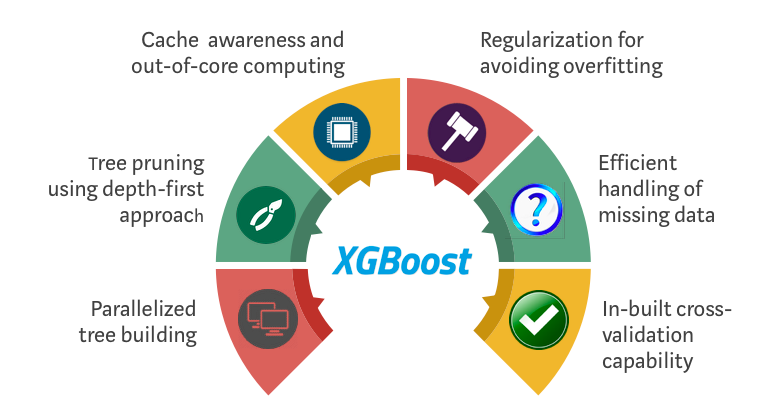

XGBoost는 최적의 예측 모델을 만들기 위한 강력한 기계 학습 알고리즘입니다. 그 중에서도 조기 종료는 모델의 학습을 빠르게 하고 과적합을 방지하는 멋진 기능입니다. 이 기능은 모델이 더 이상 개선되지 않을 때 학습을 조기에 종료시키는 방법을 제공합니다.

조기 종료 작동 원리

조기 종료는 모델이 일정한 에러율 이상으로 높아졌을 때 학습을 중단시킵니다. XGBoost에서는 ‘조기 중지 (early stopping)’ 스트레이팅지를 사용하여 학습이 진행되는 동안 최적화 지표를 모니터링합니다. 모델의 성능이 증가하지 않거나 감소한다면, 일정 횟수 동안 개선이 없다고 판단하고 학습을 종료합니다.

조기 종료 기능을 활용하면 불필요한 계산과 메모리 소비를 줄일 수 있으며, 더 빠른 모델 학습을 달성할 수 있습니다.

조기 종료 설정 방법

Python 코드를 통해 XGBoost의 조기 종료 기능을 활용하는 방법을 알아보겠습니다.

import xgboost as xgb

from sklearn.metrics import accuracy_score

from sklearn.model_selection import train_test_split

# 데이터 로드

data = pd.read_csv('data.csv')

X = data.drop('target', axis=1)

y = data['target']

# 훈련 및 테스트 데이터 분할

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# XGBoost 모델 초기화

model = xgb.XGBClassifier()

# 학습 데이터 설정

dtrain = xgb.DMatrix(X_train, label=y_train)

dtest = xgb.DMatrix(X_test, label=y_test)

# 조기 종료 설정

early_stopping_rounds = 10

watchlist = [(dtrain, 'train'), (dtest, 'test')]

# 모델 학습

model.fit(X_train, y_train, eval_metric='error', eval_set=watchlist, early_stopping_rounds=early_stopping_rounds)

# 평가 데이터에 대한 예측 수행

y_pred = model.predict(X_test)

# 정확도 계산

accuracy = accuracy_score(y_test, y_pred)

print("Accuracy:", accuracy)

위의 코드에서 early_stopping_rounds 변수는 조기 종료를 수행하기 전에 알고리즘이 개선되지 않는 횟수를 나타냅니다. eval_metric 매개 변수는 평가 지표를 설정하는데, 이 예제에서는 분류 문제에서 많이 사용되는 accuracy를 사용하였습니다.

조기 종료 기능의 장점

- 학습 속도 향상: 조기 종료를 사용하면 더 적은 학습 반복으로도 모델을 학습시킬 수 있습니다.

- 과적합 방지: 조기 종료는 모델이 일반화 오차를 최소화하는 지점에서 학습을 중지시킴으로써 과적합을 방지할 수 있습니다.

- 자원 절약: 조기 종료를 통해 필요한 계산 및 메모리 사용량을 줄일 수 있습니다.

XGBoost의 조기 종료 기능은 강력한 기능으로써, 모델 훈련 시간을 단축하고 좀 더 빠르고 효율적인 예측 모델을 구축할 수 있도록 도와줍니다.

참고 문서: